Cloudflare 最近宣布將推出 Firewall for AI。這東西就像是一個超級保鑣,專門保護那些使用大型語言模型 (LLM) 的應用程式。LLM 是那些用自然語言操作的 AI 模型,不像傳統應用程式那麼直接。這個保鑣的目的是在不良行為到達模型之前先識別它們。簡單來說,就是讓你的 AI 應用程式更安全,不被惡意者搞亂。

讓我們來看看這個 Firewall for AI 的一些精華重點:

1. 什麼是 Firewall for AI?

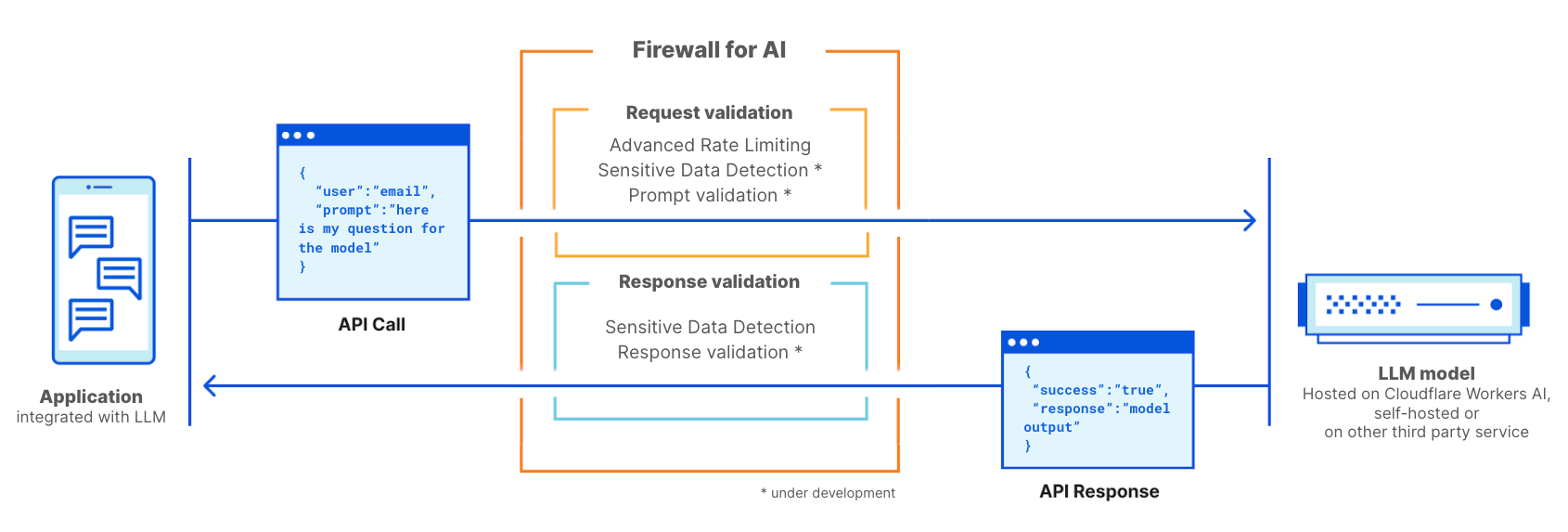

它是一個進階的 Web 應用程式防火牆,專為使用 LLM 的應用程式量身定製。它的工作方式就像一個保鑣,站在 LLM 應用程式前面,掃描每個使用者的請求,以識別可能的攻擊特徵。

LLM 與傳統應用程式的不同:

-

- 使用者互動方式:LLM 的操作是基於自然語言,與傳統應用程式的確定性操作不同。這使得識別有問題的請求比比對攻擊特徵更困難。

- 控制平面與資料互動方式:LLM 的訓練資料成為模型本身的一部分,難以控制應用程式如何將該資料作為使用者提示詞的結果分享出去。

2. LLM 十大漏洞:

OWASP 基金會發佈了 LLM 十大漏洞清單,這個清單提供了保護語言模型的有用框架。其中一些威脅類似於 OWASP 的 Web 應用程式十大漏洞,另一些則是語言模型所特有的。透過採用像 Cloudflare Firewall for AI 之類的代理安全解決方案,可以緩解這些漏洞。

這個防火牆特別關注三種模型攻擊:提示詞注入、模型拒絕服務,以及敏感資訊洩漏。它的部署方式與傳統網頁應用防火牆相似,每個帶有大型語言模型提示詞的 API 請求都會經過防火牆掃描,以偵測可能的攻擊模式和特徵。

3. LLM 部署方法:

- 內部 LLM:公司開發 LLM 來支援員工的日常任務。這些被視為公司資產,不得被非員工存取。例如,使用銷售資料和客戶互動進行訓練並用於產生定制化提案的 AI co-pilot,或者使用內部知識庫進行訓練且可供工程師查詢的 LLM。

- 公用 LLM:這些是可以在公司邊界之外存取的 LLM。這些解決方案通常有任何人都可以使用的免費版本,而且它們通常接受過一般或公共知識的訓練。範例包括 OpenAI 的 GPT 或 Anthropic 的 Claude。

- 產品 LLM:從公司的角度來看,LLM 可以成為提供給客戶的產品或服務的一部分。這些通常是定制的自托管解決方案,可以作為與公司資源互動的工具。例如客戶支援聊天機器人或 Cloudflare AI 助理。

無論哪種部署方法,都需要保護模型免遭濫用,保護模型中儲存的專有資料,以及保護終端使用者免於接觸錯誤訊息或不當內容。

4. Firewall for AI的運作方式:

它部署在 LLM 應用程式前方,並掃描每個請求以識別攻擊特徵。透過限速原則,可以控制單一工作階段的請求速率,減輕巨流量攻擊的風險。

Firewall for AI 的運作方式與傳統 Web 應用程式防火牆類似。它部署在 LLM 應用程式前方,並掃描每個請求以識別攻擊特徵。

5. 如何使用 Firewall for AI?誰有資格獲得該產品?

使用應用程式安全性進階產品的企業方案客戶可以立即開始使用進階限速和敏感資料偵測(在回應階段)。這兩種產品都可以在 Cloudflare 儀表板的 WAF 部分中找到。Firewall for AI 的提示詞驗證功能目前正在開發中,測試版將在未來幾個月內向所有 Workers AI 使用者發佈。註冊加入等候名單,並在該功能可用時收到通知。

Cloudflare是您的 AI 安全守護者,掌控資訊,保護未來

Cloudflare 是首批推出一套工具來保護 AI 應用程式的安全提供者之一。使用 Firewall for AI,客戶可以控制哪些提示詞和請求能夠到達其語言模型,從而降低濫用和資料外流的風險。請繼續關注,以瞭解有關 AI 應用程式安全性如何演變的更多資訊。如果您對於 Clouflare 與 AI 相關應用想進一步瞭解,歡迎與樂雲線上洽詢,我們會盡快回覆您!

(如欲瀏覽詳細原文,請見此: Cloudflare 宣佈推出 Firewall for AI )